44.物体检测算法:R-CNN,SSD,YOLO

目录

1.区域卷积神经网络

1.1.R-CNN

- 使用启发式搜索算法来选择锚框

- 使用预训练模型来对每个锚框抽取特征(每个锚框当作一个图片,用CNN)

- 训练一个SVM来类别分类(神经网络之前,category pre

分类标签归档:python

数据增广不仅用于处理图片,也可用于文本和语音,这里只涉及到图片。

采集数据得到的训练场景与实际部署场景不同是常见的问题,这种变化有时会显著影响模型表现。在训练集中尽可能模拟部署时可能遇到的场景对模型的泛化性十分重要。

数据增强是指在一个已有数据集上操作使其有更多的多样性。对语音来说可以加入不同的背景噪音,对图片而言可以改变其颜色,形状等。

一般来说不会先将数据集做增广后存下来再用于训练;而是直接在线生成,从原始数据中读图片

主内存->L3->L2->L1->寄存器

深层神经网络的训练,尤其是使网络在较短时间内收敛是十分困难的,批量归一化[batch normalization]是一种流行且有效的技术,能加速深层网络的收敛速度,目前仍被广泛使用。

深度神经网络在训练时会遇到一些问题:

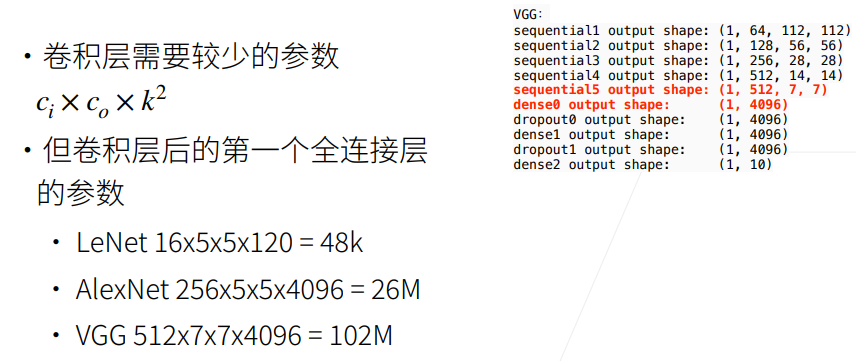

全连接层的问题

以VGG为例(图示),全连接层需要先Flatten,输入维度为512x7x7,输出维度为4096,则需要参数个数为512x7x7x4096=102M。

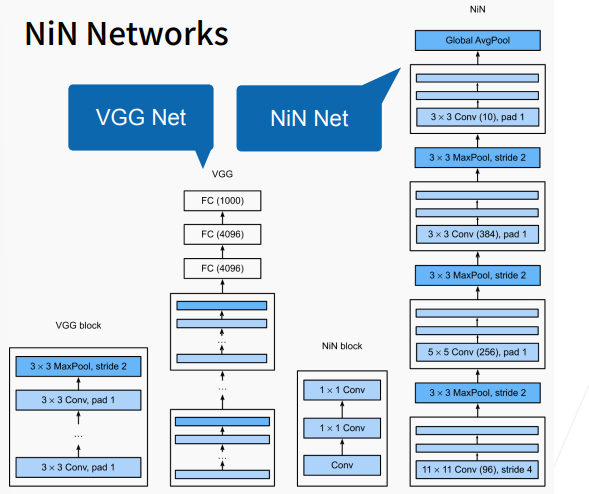

NiN架构如上图右边所示,若干个Ni