58 深层循环神经网络

目录

1.深层循环神经网络

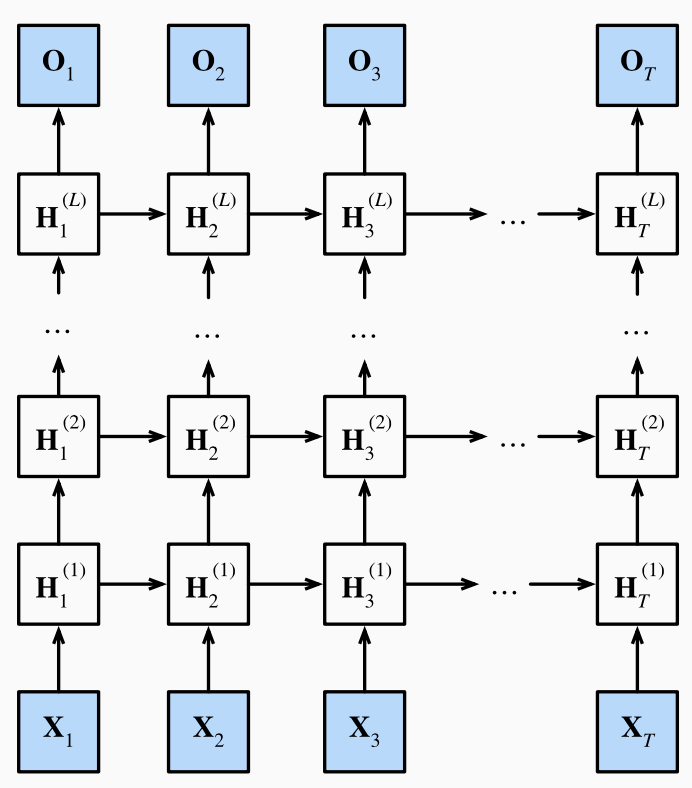

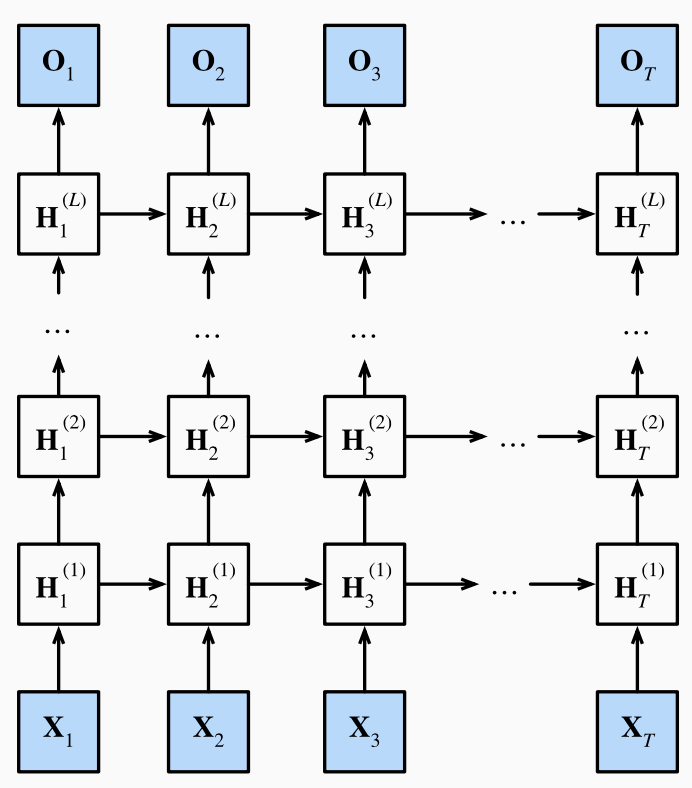

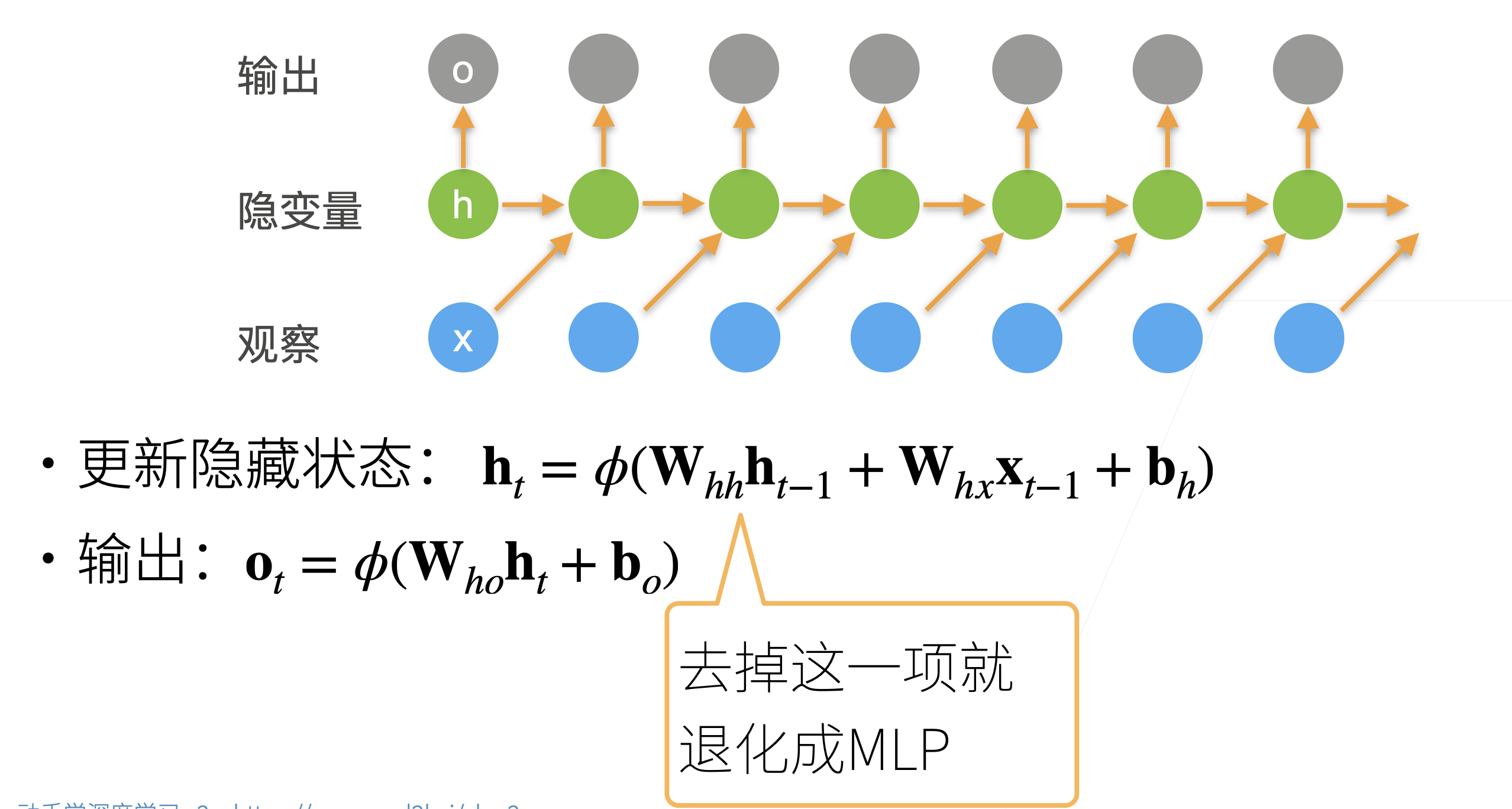

之前讲的RNN都只有一个隐藏层(序列变长不算是深度),而一个隐藏层的RNN一旦做的很宽就容易出现过拟合。因此我们考虑将网络做的更深而非更宽,每层都只做一点非线性,靠层数叠加得到更加非线性的模型。

浅RNN:输入-隐层-输出

深RNN:输入-隐层-隐层-...-输出

(课程视频中的图片有错误,最后输出层后一时间步是不受前一步影响的,即没有箭头)

(课程视频中的图片有错误,最后输出层后一时间步是不受前一步影响的,即没有箭头)

分类标签归档:python

之前讲的RNN都只有一个隐藏层(序列变长不算是深度),而一个隐藏层的RNN一旦做的很宽就容易出现过拟合。因此我们考虑将网络做的更深而非更宽,每层都只做一点非线性,靠层数叠加得到更加非线性的模型。

浅RNN:输入-隐层-输出

深RNN:输入-隐层-隐层-...-输出

(课程视频中的图片有错误,最后输出层后一时间步是不受前一步影响的,即没有箭头)

(课程视频中的图片有错误,最后输出层后一时间步是不受前一步影响的,即没有箭头)

可以说,长短期记忆网络的设计灵感来自于计算机的逻辑门。 长短期记忆网络引入了记忆元(memory cell),或简称为单元(cell)。 有些文献认为记忆元是隐状态的一种特殊类型, 它们与隐状态具有相同的形状,其设计目的是用于记录附加的信息。 为了控制记忆元,我们需要许多门。 其中一个门用来从单元中输出条目,我们将其称为输出门(output gate)。 另外一个门用来决定何时将数据读入单元,我们将其称为输入门(input gate)。 我们还需要一种机制来

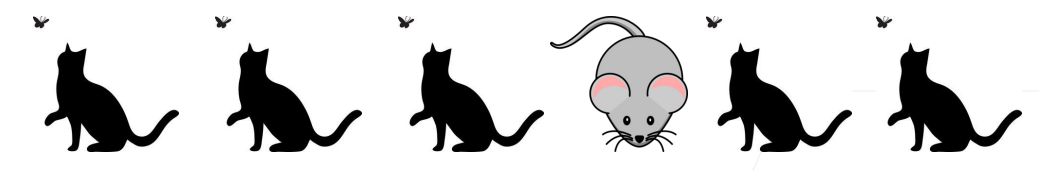

比如上图中的序列,若干个猫中出现了一个鼠,那么我们应该重点关注这个鼠,而中间重复出现的猫则减少关注。文本序列同理,通常长文本我们需要关注的是几个关键词,关键句。

更新门Zt,重置门Rt的公式大体相同,唯一不同的是学习到的参数。

需要注意的是,计算门的方式和原来RNN的实现中计算新的隐状态相似,只是激活函数改成了sig

样式迁移类似于手机相机中的滤镜,指的是给定内容图片和风格图片,合成一张新的图片,使得他的内容与内容图片相似,而风格却是风格图片的样子,如下例:

如下图所示,可以用一个预训练好的神经网络来实现样式迁移:

代码

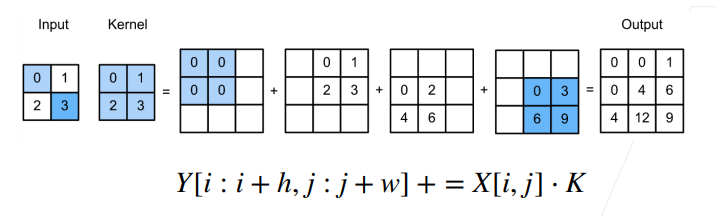

如图所示,input里的每个元素和kernel相乘,最后把对应位置相加,相当于卷积的逆变换

如图所示,input里的每个元素和kernel相乘,最后把对应位置相加,相当于卷积的逆变换

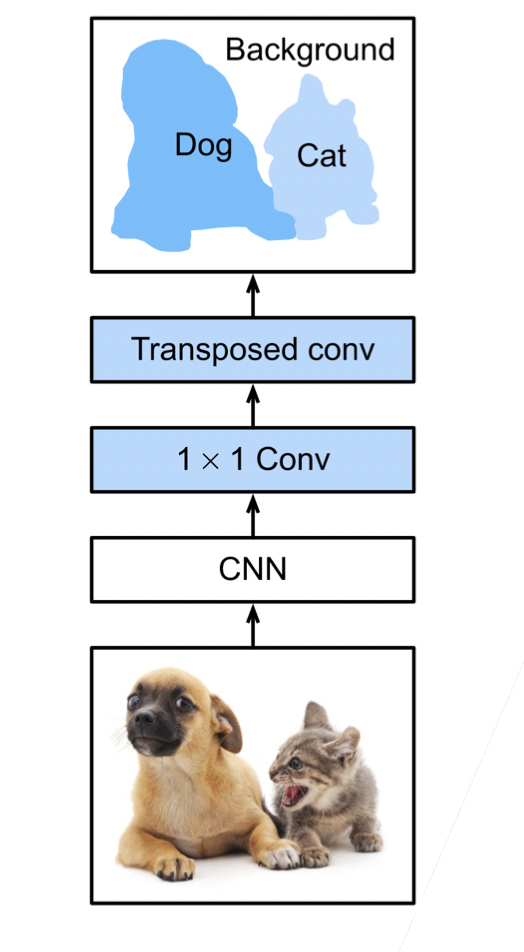

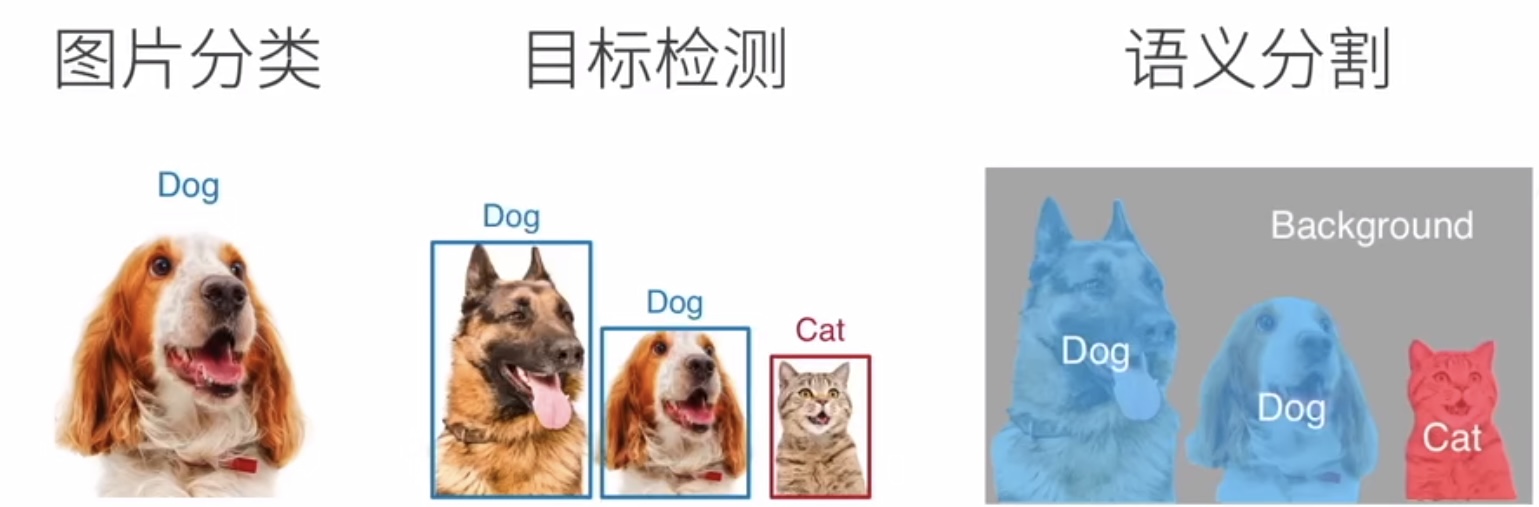

有时只能实现框选的目标检测还是太粗糙了,无法得到更精细的信息。语义分割将图片中的每个像素分类到对应的类别。

分割这一概念在计算机视觉中由来已久。最早的图片分割对给定图片使用聚类等方法把语义上比较像的像素放在一起,但通常不会告诉我们这些像素到底是什么。而语义分割可以告诉我们每个像素对应的label是什么。

这也意味着我们需要对图片的每一个像素都做label,使得语义分割成为了一个比较精细且大的任务。语义分割的数据集成本也较高,往往规模小像素高。常用的数据集之一是Pascal VOC2012。

背景