25 使用块的网络 VGG

目录

Alexnet最大的问题在于长得不规则,结构不甚清晰,也不便于调整。想要把网络做的更深更大需要更好的设计思想和标准框架。

1. VGG块

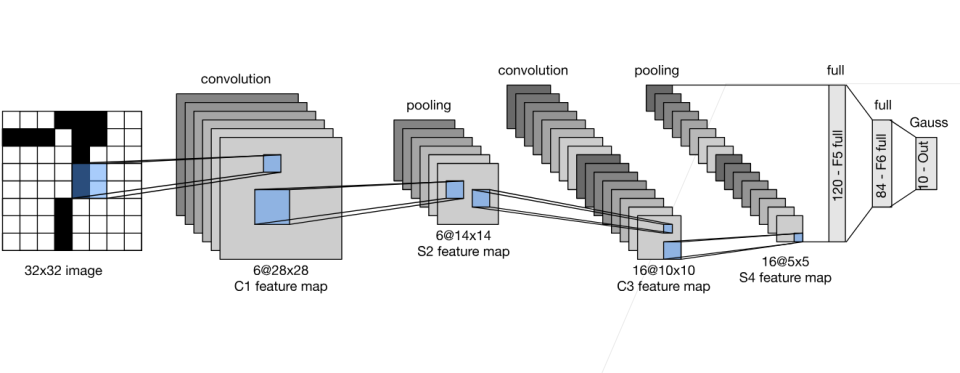

直到现在更深更大的模型也是我们努力的方向,在当时AlexNet比LeNet更深更大得到了更好的精度,大家也希望把网络做的更深更大。选择之一是使用更多的全连接层,但全连接层的成本很高;第二个选择是使用更多的卷积层,但缺乏好的指导思想来说明在哪加,加多少。最终VGG采取了将卷积层组合成块,再把卷积块组合到一起的思路。

VGG块可以看作是AlexNet思路的拓展,A

注意:第三点可以当做结论来记(Same卷积或Val

注意:第三点可以当做结论来记(Same卷积或Val