- 物体检测

- 边缘框实现

- 数据集

41 物体检测和数据集

物体检测

- 图片分类和目标检测在任务上的区别:图片分类已知有一个确定目标,任务是识别该目标属于何种分类,而目标检测不仅需要检测出图片中所有感兴趣的目标类别,并确定其位置,所以目标检测要比图片分类更复杂应用场景更广。

- 图片分类和目标检测在数据集上的区别:由于目标检测中每一张图片可能存在多个目标,每个目标我们不仅需要分类,还需要确定边缘框以给出目标位置信息,因此目标检测数据集的标注成本要显著高于图片分类,也就导致了目标检测数据集较小。

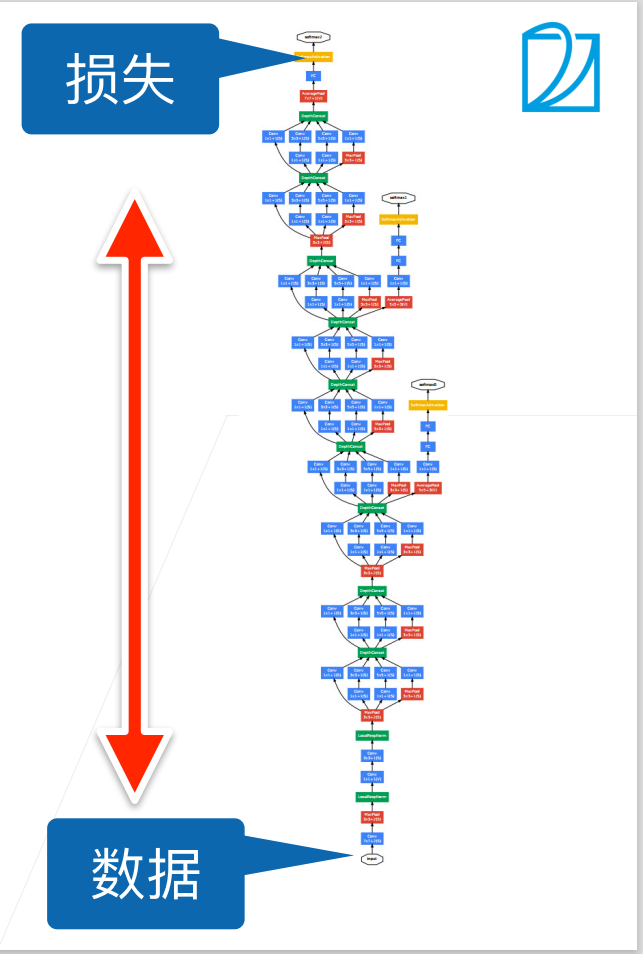

- 边缘框:用一个尽量小矩形框将目标物体大体框起来,边框的位置信息就可以表

主要分为五部

主要分为五部