近年来YOLO系列层出不穷,更新不断,已经到v7版本。本人认为不能简单用版本高低来评判一个系列的效果好坏,YOLOv1-v7不同版本各有特色,在不同场景,不同上下游环境,不同资源支持的情况下,如何从容选择使用哪个版本,甚至使用哪个特定部分,都需要我们对YOLOv1-v7有一个全面的认识。 故本人将YOLO系列每个版本都表示成下图中的五个部分,逐一进行解析,并将每个部分带入业务侧,竞赛侧,研究侧进行延伸思考,探索更多可能性。 【Make YOLO Great Again】YOLOv1-v7全系列大解析(Neck篇)已经发布,大家可按需取用~ 而本文将聚焦于Head侧的分享,希望能让江湖中的英雄豪

作者文章归档:justlin_01

预训练时代下的文本生成|模型&技巧

最近没看到啥好玩的NLP文章,于是开始读综述了。今天推荐一篇人大出品的37页文本生成综述:

A Survey of Pretrained Language Models Based Text Generation

https://arxiv.org/abs/2201.05273

虽然综述读起来累些,但多读综述有利于知识体系的梳理。而且NLP领域的综述读多了会发现,很多优化方法都是相通的,也能提供一些新的思路。

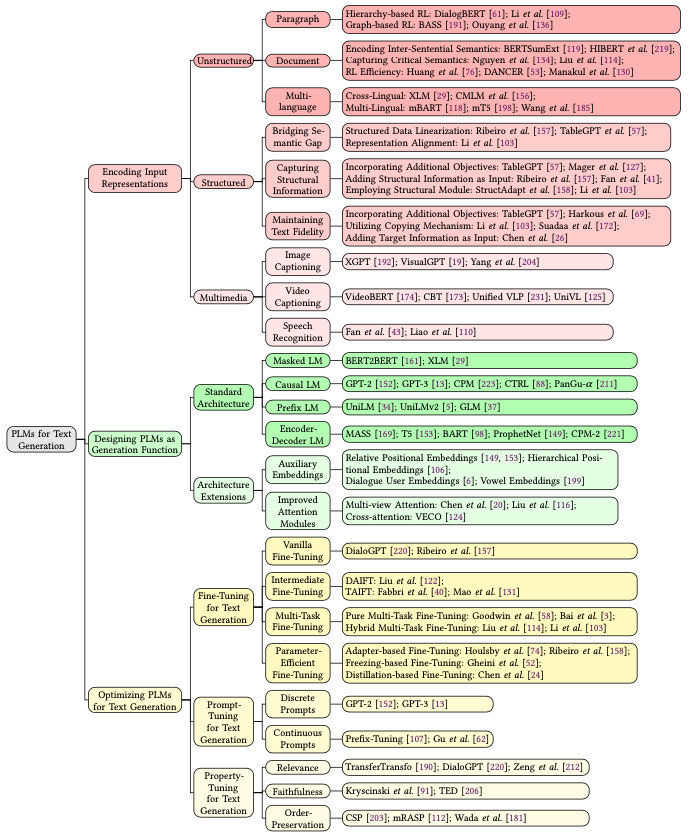

这篇文章从把文本生成的方法分成了三类:输入编码、模型设计、优化方法。同时也从数据、模型、优化层面给出了下面我们就顺着文章的思路,梳理一下最近几年文本生成领域的进展。

虽然综述读起来累些,但多读综述有利于知识体系的梳理。而且NLP领域的综述读多了会发现,很多优化方法都是相通的,也能提供一些新的思路。

这篇文章从把文本生成的方法分成了三类:输入编码、模型设计、优化方法。同时也从数据、模型、优化层面给出了下面我们就顺着文章的思路,梳理一下最近几年文本生成领域的进展。

如何编码输入

这

哈工大|15种NLP数据增强方法总结与对比

这篇40多页的综述出自哈工大车万翔老师的团队,一共总结了15种NLP可以用到的数据增强方法、优缺点,还有一些使用技巧,十分良心。下面就速读一下,如果要使用的话还是建议参考原文以及其他文献的应用细节。 论文:Data Augmentation Approaches in Natural Language Processing: A Survey 地址:https://arxiv.org/abs/2110.01852

数据增强方法

数据增强(Data Augmentation,简称DA),是指根据现有数据,合成新数据的一类方法。毕竟数据才是真正的效果天花板,有了更多数据后可以提升效果、增强模型泛化

文本语义相似度脉络

本文旨在帮大家快速了解文本语义相似度领域的研究脉络和进展,其中包含了文本语义相似度任务的处理步骤,文本相似度模型发展历程,相关数据集,以及重要论文分享。

文本相似度任务处理步骤

通过该领域的大量论文阅读,我认为处理文本相似度任务时可以分为一下三个步骤: 预处理:如数据清洗等。此步骤旨在对文本做一些规范化操作,筛选有用特征,去除噪音。 文本表示:当数据被预处理完成后,就可以送入模型了。在文本相似度任务中,需要有一个模块用于对文本的向量化表示,从而为下一步相似度比较做准备。这个部分一般会选用一些 backbone 模型,如 LSTM,BERT 等。 学习范式的选择: 这个步骤也是文本相似度任务中最

SimCSE详解

「句向量表征技术」一直都是NLP领域的热门话题,在BERT前时代,一般都采用word2vec训练出的word-embedding结合pooling策略进行句向量表征,或者在有训练数据情况下,采用TextCNN/BiLSTM结合Siamese network策略进行句向量表征。在BERT时代,人们借助预训练语言模型的固有优势,一般采用BERT模型的[CLS]向量作为句向量表征;Sentence-Bert诠释了在存在训练数据的情况下,如何在BERT模型上获取更好的句向量表征。后面又有了「BERT-Flow」、「BERT-Whitenning」、「ConSERT」、「SimCSE」、「R-Drop」

Sentence-BERT详解

Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks; 论文地址:https://arxiv.org/abs/1908.10084; 论文代码:https://github.com/UKPLab/ sentence-transformers。

Introduction

Bert模型已经在NLP各大任务中都展现出了强者的姿态。在语义相似度计算(semantic textual similarity)任务上也不例外,但是,由于bert模型规定,在计算语义相似度时,需要将两个句子同时进入模型,进行信息交互,这造成大量的计算开销。

BART详解

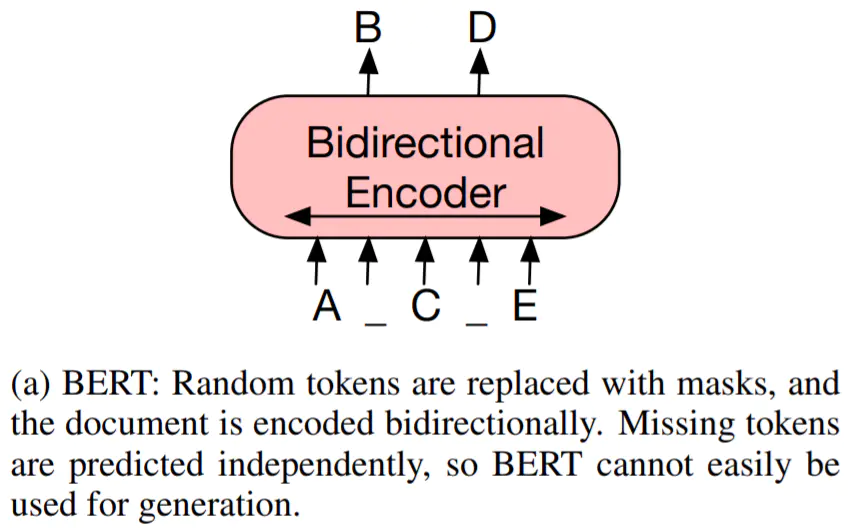

一切都得从 Transformer 说起。Transformer 左半边为 Encoder,右半边为 Decoder。我们将 Encoder 输入的句子称为 source,Decoder 输入的句子称为 target

Encoder 负责将 source 进行 self-attention 并获得句子中每个词的 representation,最经典的 Encoder 架构就是 BERT,通过 Masked Language Model 来学习词之间的关系,另外还有 XLNet, RoBERTa, ALBERT, DistilBERT 等等。但是单独 Encoder 结构不适用于生成任务

D

百度事件图谱技术与应用

导读:目前百度事件图谱已构建了千万级规模的事件图谱,在收录时效上达到分钟级。 事件图谱技术已应用到搜索、信息流等百度内部的产品中,相关能力也对外输出到媒 体等多个行业。另外,事件图谱的前沿推理技术在金融领域的探索也初步取得成果, 并已形成一个金融事件归因和预测的推理平台。本文将为大家详细介绍百度的事件图 谱技术与应用,主要内容包括: 事件图谱概述 事件图谱技术 事件图谱应用 总结与展望

01 事件图谱概述

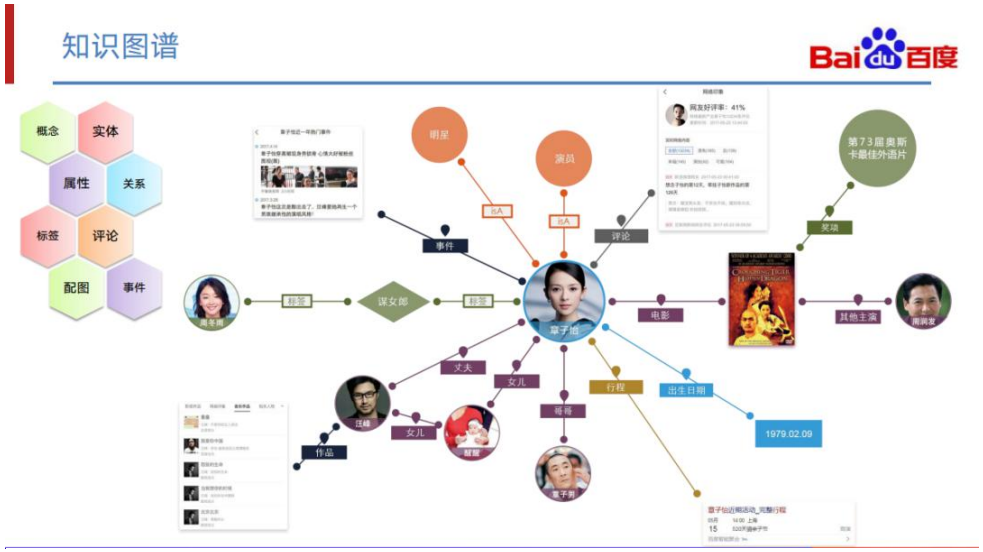

1. 知识图谱

知识图谱构建的目的,其实是为了把世界上纷繁复杂的、各种各样的客观事实通过图 谱的方式组织起来,让机器能够通过这个图谱更好地实现理解、抽取、推理等任务, 从而

动手学习深度学习系列笔记——导读

前言

《动手学习深度学习》是李沐老师(AWS 资深首席科学家,美国卡内基梅隆大学计算机系博士)主讲的一系列深度学习视频。本笔记记录了该课程的重点知识。

课程简介

通常我们提到深度学习,常常会忘记深度学习只是机器学习的一小部分,而认为它是独立于机器学习的单独模块。这是因为机器学习作为一门历史更悠久的学科,在深度学习没有问世之前,在现实世界的应用范围很窄。在语音识别、计算机视觉、自然语言处理等领域,由于需要大量的领域知识并且现实情况异常复杂,机器学习往往只是解决这些领域问题方案中的一小部分。但是就在过去的几年里,深度学习的问世和应用给世界带来了惊喜,推动了计算机视觉、自然语言处理、自动语音识别、强